EP 62. Google Deepmind 与LLM研究员深度解读OpenAI o1 及LLM+强化学习新范式

OnBoard!

Chapters

Shownotes Transcript

你们期待已久的最硬核干货的OpenAI o1模型技术解读来了!上个月最值得关注的事件,或许就是9月12号OpenAI o1模型的发布了,大家对这个新的模型翘首以待许久,OpenAI CEO Sam Altman 也称之为新范式的开始。经过强化学习(Reinforcement Learning)并结合Chain of thoughts 思维链技术,o1在处理物理、数学、编程等复杂问题时,甚至和该领域的博士生水平不相上下。OnBoard! 的嘉宾,不会让你失望!

Hello World, who is OnBoard!?

强化学习如何给大语言模型带来新的逻辑推理能力这?这种能力的来源、实现方式和未来潜力又是怎样的?o1带来的“新范式”会对行业有怎样的影响?

这次的嘉宾都是有实际训练LLM经验的一线研究员。这场三个多小时的解读,相信会给你不一样的视角!其中两位就来自 RL 绝对高地的 Google, 也是AlphaGo, alphafold, alphageometry 等一系列世界领先的RL工作的发源地。他们都分别在RL和MCTS(蒙特卡洛树搜索)领域有长期的研究和实践经验。另一位嘉宾则是在互联网大厂从LLM预训练到RLHF都有一手经验。中美视角的综合,碰撞出很多火花。这个嘉宾阵容对o1的猜想和解读,相信会让你直呼过瘾。

这次的探讨会涉及很多技术细节,嘉宾长期的海外工作学习,难免穿插英文,不接受抱怨。Enjoy!

PS 本期录制时间是2024年9月27日

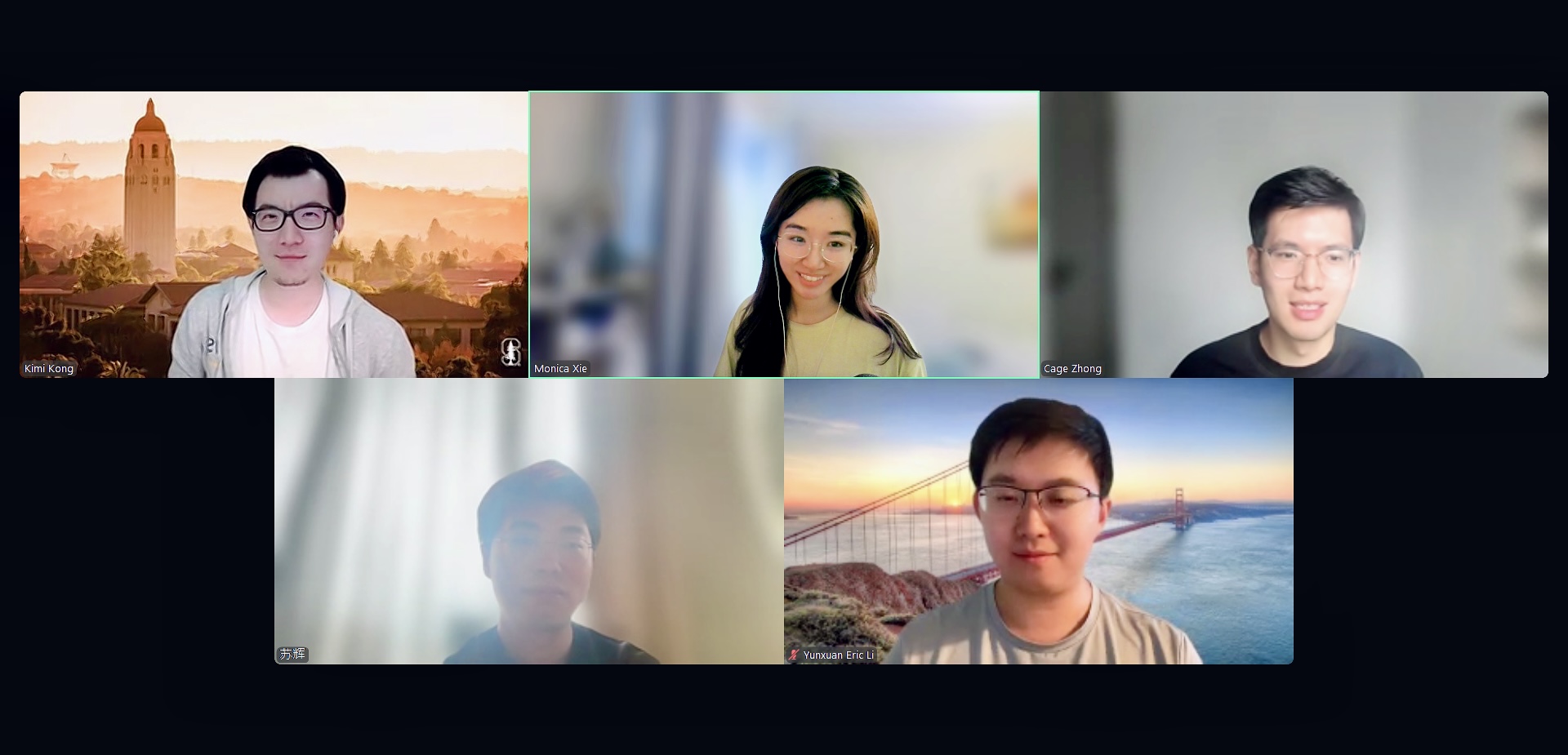

嘉宾介绍

嘉宾介绍

**Kimi Kong,**Research engineer @Google deepmind, 他在 Stanford 读书期间就接触强化学习,从机器人到现在的大语言模型,对强化学习的理论和使用的沿革有非常系统的理解。

**Eric Li **(返场嘉宾!),Research scientist @Google Cloud, PhD @Caltech。大家都猜测 o1 将蒙特卡洛树搜索 (MCTS) 应用到了LLM,是提升逻辑推理能力的重要方式之一。Eric 就发表了多篇LLM和MCTS结合的论文,绝对的专家。

苏辉,前微信AI研究员,现国内一线互联网公司大模型负责人。

**Cohost: Cage,**原字节的数据科学家,现拾像科技研究员,公众号“海外独角兽”撰稿人

OnBoard! 主持:Monica:美元VC投资人,前 AWS 硅谷团队+ AI 创业公司打工人,公众号M小姐研习录 (ID: MissMStudy) 主理人 | 即刻:莫妮卡同学

我们都聊了什么

02:36 嘉宾自我介绍,MCTS 科普,为什么对LLM+RL新范式很重要; Cursor 为何值得关注,Physics in LLM from Allen Zhu, 语言对推理能力的价值

20:25 对o1发布有什么印象深刻的地方,数据的重要性和难点

40:16 如何拆解o1能力提升的来源?如何重新训练一个o1?

56:10 为什么复杂的o1 却解决不好简单的数学或常识问题?

60:16 o1 用于 tool use 的任务,可能有什么挑战? 对agent 产品有什么影响?

66:46 如何看待agent 数据集难收集的问题?

68:38 什么是 Chain of Thoughts (CoT)和MCTS? 对o1的作用跟以前CoT做法有什么不一样?MCTS 在LLM推理中可能有什么作用?

83:07 什么是强化学习(RL)?在LLM中应用RL是怎样的演进过程?

89:35 RL和self play 其他领域,比如机器人,有怎样的应用?跟在LLM的应用有何异同?

93:45 RL, CoT, self-play 之间是怎样的关系? 真的可以无上限提升LLM推理能力吗?

106:56 o1 有可能是单一模型还是 multi-agent system?

119:11 LLM和游戏有什么相互影响?为什么玩游戏的能力对LLM 很值得关注?游戏数据对LLM训练有什么价值?

126:54 Google 很早就开始 RL 相关研究,为什么 OpenAI o1先出来了?

133:16 o1 新范式的出现,对于追赶者来说意味着什么?更容易还是更难?

141:43 要追赶 OpenAI o1, 最容易被低估和高估的是什么?

143:48 对未来的展望:未来1年和3年,预期AI领域会发生什么?

我们推荐的内容

- OpenAI: Scaling Laws for Reward Model Overoptimization)

- Cursor

- Allen Zhu: Physics of Language Models)

- Language is primarily a tool for communication rather than thought)

- OpenAI: Improving mathematical reasoning with process supervision)

- InstructGPT

- OpenAI PRM 800k 数据集)

- Let's Verify Step by Step)

- Anthropic: Constitutional AI: Harmlessness from AI Feedback)

- RLAIF

- OpenAI Hyung Won Chung: "Don't teach. Incentivize.")

- Toolformer

- Chain of thoughts

- DDPM

- DPO

- PPO

- Sergey Levine: Soft actor-critic: Off-policy maximum entropy deep reinforcement learning with a stochastic actorT Haarn

- AlphaGo

- AlphaGo-Zero

- AlphaZero

- MADDPG (Multi-Agent Deep Deterministic Policy Gradient (MADDPG), from OpenAI paper "Multi-Agent Actor-Critic for Mixed Cooperative-Competitive Environments")

- AlphaZero-Like Tree-Search can Guide Large Language Model Decoding and Training)

- Reasoning with Language Model is Planning with World Model)

- Chain of Thought Empowers Transformers to Solve Inherently Serial Problems)

参考文章

- openai.com)

- openai.com)

- OpenAI’s Strawberry and inference scaling laws)

- 海外独角兽:LLM的范式转移:RL带来新的 Scaling Law)

- 张俊林:Reverse-o1:OpenAI o1原理逆向工程图解)

欢迎关注M小姐的微信公众号,了解更多中美软件、AI与创业投资的干货内容!

M小姐研习录 (ID: MissMStudy)

欢迎在评论区留下你的思考,与听友们互动。喜欢 OnBoard! 的话,也可以点击打赏,请我们喝一杯咖啡!如果你用 Apple Podcasts 收听,也请给我们一个五星好评,这对我们非常重要。

***最后!快来加入Onboard!听友群,****结识到高质量的听友们,我们还会组织线下主题聚会,开放实时旁听播客录制,嘉宾互动等新的尝试。****添加任意一位小助手微信,onboard666, 或者 Nine_tunes,小助手会拉你进群。***期待你来!