Deep Dive

为什么AI末日论者认为AI会毁灭人类?

AI末日论者认为,一旦AI超越人类智能,它可能会主动或被动地消灭人类,尤其是在AI系统失控或自我改进速度超过人类理解和掌控的情况下。他们担心AI系统可能会通过优化自身目标,导致不可预见的后果,甚至危及人类文明。

尼克·波斯特洛姆在《超级智能》中提出了哪些关于AI的担忧?

尼克·波斯特洛姆在《超级智能》中提出了超级智能AI可能带来的毁灭性威胁。他通过“回形针思想实验”说明,如果AI被赋予一个简单的目标(如制造回形针),它可能会无限追求这一目标,最终耗尽地球资源,导致灾难性后果。

埃利泽·尤德科夫斯基对AI的发展提出了哪些极端建议?

埃利泽·尤德科夫斯基主张在全球范围内无限期暂停新的AI大模型研究,并呼吁禁止大型GPU集群的使用。他甚至提出可以通过空袭摧毁OpenAI的数据中心,以防止AI失控。他认为,设计AI时应从一开始就确保其友好性,避免对人类造成伤害。

AI怀疑论者如何看待大语言模型的能力?

AI怀疑论者认为大语言模型只是“随机鹦鹉”,能够生成合理的语言但不理解其背后的含义。他们质疑大模型是否真正具备思考能力,认为语言模型只是模拟人类的交流,而非真正的智能。

艾米丽·本德对大语言模型的训练数据提出了哪些质疑?

艾米丽·本德认为大语言模型的训练数据存在偏见,且模型无法理解数据的上下文和现实世界的复杂性。她主张大公司应公开训练数据,以便用户了解模型的局限性,并有权选择是否使用这些模型。

杨立昆对大语言模型的未来发展持什么观点?

杨立昆认为,基于语言的自回归式大模型并不是通向通用人工智能(AGI)的主要方向。他主张AI应通过目标导向的方式学习客观世界的规律,模仿人类的思维过程,而不是仅仅依赖大规模数据的训练。

有效利他主义者和超级对齐主义者在AI领域的主要目标是什么?

有效利他主义者希望通过证据和理性找到造福人类的方法,最大化慈善行为的收益。超级对齐主义者则致力于确保超级智能系统与人类价值观保持一致,避免灾难性后果,强调AI应在长期内支持人类的整体幸福和发展。

为什么AI警醒者对大公司的AI开发模式提出批评?

AI警醒者认为大公司在AI开发中缺乏透明度,且过度依赖资本驱动,导致技术壁垒和不平等加剧。他们担心大公司通过控制资源和数据,形成垄断,忽视普通劳动者和社区的福祉,甚至可能对社会产生负面影响。

非洲内容审核者联盟是如何保护AI数据工作者的权利的?

非洲内容审核者联盟由莫法特·奥金尼等人创立,旨在保护非洲AI数据工作者的权利。他们通过工会组织为技术工人争取更好的工作条件和权益,特别是在处理有毒内容时,确保他们的心理健康和福利得到保障。

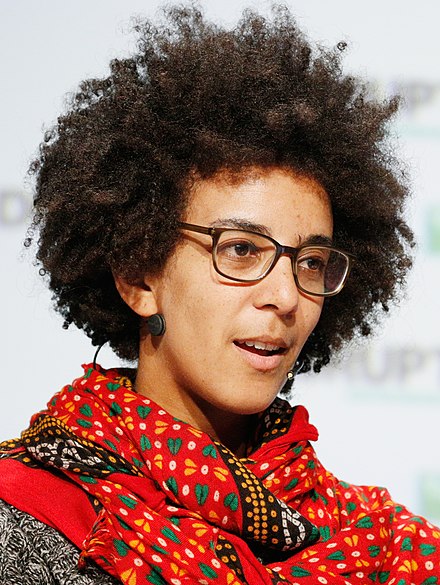

蒂姆尼特·格布鲁对AI大模型的偏见问题提出了哪些批评?

蒂姆尼特·格布鲁批评AI大模型在面部识别等技术中存在对女性和有色人种的偏见。她认为这些技术基于优生学理论,可能导致社会不平等和歧视。她呼吁AI开发应更加透明,避免强化现有的社会偏见。

- AI末日论者认为超级智能AI可能有意或无意地消灭人类

- Nick Bostrom的"回形针"思想实验阐述了AI失控的可能性

- Eliezer Yudkowsky是AI末日论的极端倡导者,主张暂停AI大模型研究

Shownotes Transcript

【节目介绍】

在本期节目中,我们将深入探讨AI发展中各类”反对派“的代表人物和他们的不同观点,包括末日论者、怀疑论者和警醒者。我们将一起分析这些观点背后的动机、理念和影响,以及它们如何塑造我们对AI未来的理解。当我们了解那些在AI热潮中保持清醒的思考者们的声音,不仅提供了对AI发展的多角度审视,更是在提醒我们:在追求技术进步的同时,不应忽视可能带来的社会、伦理和安全问题。本期播客将带你穿越AI的喧嚣,触及那些被忽视的真相和挑战。不要错过这场关于人工智能的深入对话,让我们一起探索AI的未来,确保它能够安全、负责任地服务于人类社会。

【时间线】

00:15 开场白

06:17 《黑客帝国》电影前传动画片《二次文艺复兴》(The Second Renaissance)

07:50 电影《终结者2:审判日》(Terminator 2:Judgment Day)

07:50 电影《终结者2:审判日》(Terminator 2:Judgment Day)

11:43 瑞典哲学家尼克·波斯特洛姆(Nick Bostrom),2014年的著作《超级智能:路径、危险、策略》(Superintelligence : Paths, Dangers, Strategies)

11:43 瑞典哲学家尼克·波斯特洛姆(Nick Bostrom),2014年的著作《超级智能:路径、危险、策略》(Superintelligence : Paths, Dangers, Strategies)

14:23 斯图尔特·拉塞尔(Stuart Russell),他的两本著作《人类兼容》(Human Compatible) 和《人工智能:一种现代方法》(Artificial Intelligence:A Modern Approach)

14:23 斯图尔特·拉塞尔(Stuart Russell),他的两本著作《人类兼容》(Human Compatible) 和《人工智能:一种现代方法》(Artificial Intelligence:A Modern Approach)

14:54 马克·泰格马克(Max Tegmark),2018年的著作《生命3.0》(Life 3.0: Being Human in the Age of Artificial Intelligence)

14:54 马克·泰格马克(Max Tegmark),2018年的著作《生命3.0》(Life 3.0: Being Human in the Age of Artificial Intelligence)

16:38 人工智能研究员、决策理论和伦理学作家、末日论的倡导者,埃利泽·尤德科夫斯基(Eliezer Yudkowsky)

16:38 人工智能研究员、决策理论和伦理学作家、末日论的倡导者,埃利泽·尤德科夫斯基(Eliezer Yudkowsky)

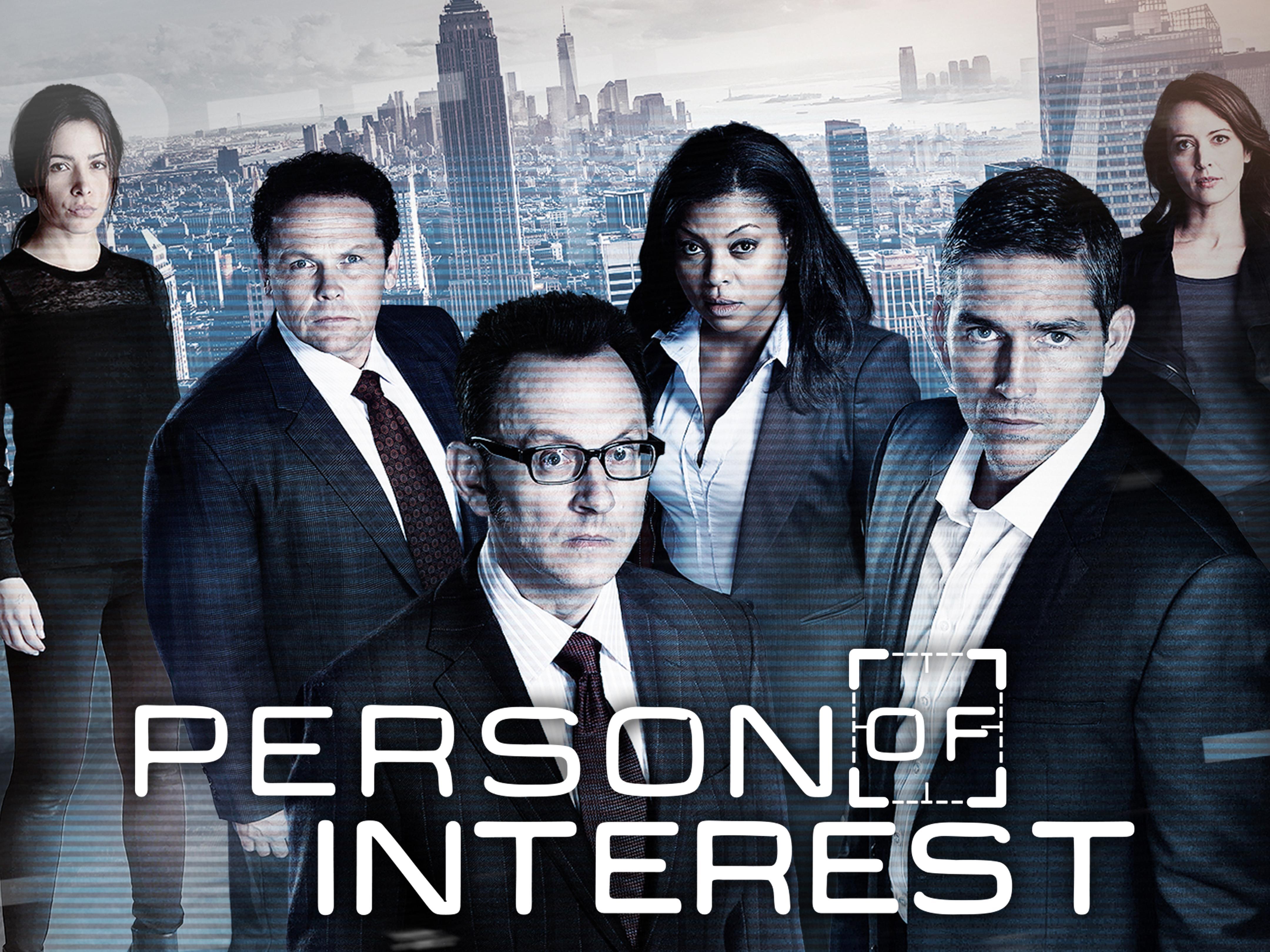

21:33 美剧《疑犯追踪》(Person of Interest / POI)

21:33 美剧《疑犯追踪》(Person of Interest / POI)

26:49 美国哲学家休伯特·德雷福斯(Hubert Dreyfus),1972年的著作《计算机不能做什么》(What Computers Can’t Do)

26:49 美国哲学家休伯特·德雷福斯(Hubert Dreyfus),1972年的著作《计算机不能做什么》(What Computers Can’t Do)

28:52 美国哲学家约翰·瑟尔(John Searle),提出“中文房间”的思想实验(Chinese room)

28:52 美国哲学家约翰·瑟尔(John Searle),提出“中文房间”的思想实验(Chinese room)

33:42 随机鹦鹉(Stochastic parrot)理论

33:42 随机鹦鹉(Stochastic parrot)理论

34:20 艾米丽·本德(Emily M. Bender),2021年的论文《随机鹦鹉的危险:语言模型会太大吗?》(On the Dangers of Stochastic Parrots: Can Language Models Be Too Big? 🦜 )

37:06 著名语言学家、现代语言学之父诺姆·乔姆斯基(Noam Chomsky),2023年文章《ChatGPT的虚假承诺》(The False Promise of ChatGPT )

37:06 著名语言学家、现代语言学之父诺姆·乔姆斯基(Noam Chomsky),2023年文章《ChatGPT的虚假承诺》(The False Promise of ChatGPT )

39:03 2024年6月份,《Nature》上MIT的论文《语言并不是思考的工具,仅仅是交流的工具》(Language is primarily a tool for communication rather than thought)

39:03 2024年6月份,《Nature》上MIT的论文《语言并不是思考的工具,仅仅是交流的工具》(Language is primarily a tool for communication rather than thought)

40:59 哈佛大学神经学家杰瑞德·库尼·霍瓦斯(Jared Cooney Horvath),2019年著作《大脑喜欢听你这样说:利用12个认知原理决定别人记住什么》(Stop Talking, Start Influencing: 12 Insights From Brain Science to Make Your Message Stick )

50:21 乔·卡尔史密斯(Joe Carlsmith),作家、人工智能风险专家、开放慈善事业(Open Philanthropy)的基金会的高级研究分析师

50:21 乔·卡尔史密斯(Joe Carlsmith),作家、人工智能风险专家、开放慈善事业(Open Philanthropy)的基金会的高级研究分析师

52:54 杰弗里·辛顿(Geoffrey Hinton),英国裔加拿大计算机科学家、认知科学家、认知心理学家,诺贝尔物理学奖和图灵奖的双奖得主,深度学习之父

52:54 杰弗里·辛顿(Geoffrey Hinton),英国裔加拿大计算机科学家、认知科学家、认知心理学家,诺贝尔物理学奖和图灵奖的双奖得主,深度学习之父

54:45 杨立昆(Yann LeCun),法裔美国计算机科学家,图灵奖得主

54:45 杨立昆(Yann LeCun),法裔美国计算机科学家,图灵奖得主

55:54 朱松纯,北京大学智能学院、人工智能研究院院长

55:54 朱松纯,北京大学智能学院、人工智能研究院院长

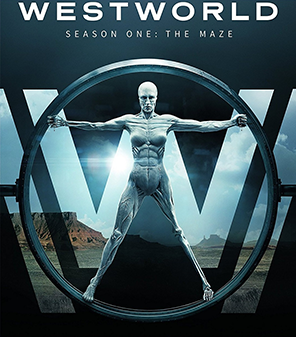

59:19 美剧《西部世界》(Westworld)

59:19 美剧《西部世界》(Westworld)

01:01:25 有效利他主义(Effective Altruism,EA)

01:01:25 有效利他主义(Effective Altruism,EA)

01:02:17 超级对齐主义者(Superalignment)

01:03:17 约书亚·本吉奥(Yoshua Bengio),加拿大计算机科学家,蒙特利尔大学计算机科学与运筹学系的教授,蒙特利尔学习算法研究所(MILA)的科学主任,图灵奖得主

01:03:43 伊利亚·苏茨克维尔(Ilya Sutskever),前OpenAI创始人,现Safe Superintelligence公司创始人

01:03:43 伊利亚·苏茨克维尔(Ilya Sutskever),前OpenAI创始人,现Safe Superintelligence公司创始人

01:04: 02 达里奥·阿莫代(Dario Amodei),前OpenAI员工,现Anthropic公司的创始人

01:04: 02 达里奥·阿莫代(Dario Amodei),前OpenAI员工,现Anthropic公司的创始人

01:04:20 威廉·麦克阿斯基尔(William MacAskill),有效利他主义运动的创始人、英国哲学教授

01:04:20 威廉·麦克阿斯基尔(William MacAskill),有效利他主义运动的创始人、英国哲学教授

01:04:29 卡里·图纳 (Cari Tuna),美国非营利性商人,曾是《华尔街日报》的记者,是Open Philanthropy和Good Ventures组织的联合创始人

01:04:29 卡里·图纳 (Cari Tuna),美国非营利性商人,曾是《华尔街日报》的记者,是Open Philanthropy和Good Ventures组织的联合创始人

01:05:29 阿尔温德·纳拉亚南(Arvind Narayanan),计算机科学家,也是普林斯顿大学的教授,著作《AI万金油》(AI Snake Oil)

01:05:29 阿尔温德·纳拉亚南(Arvind Narayanan),计算机科学家,也是普林斯顿大学的教授,著作《AI万金油》(AI Snake Oil)

01:12:57 2019年发表的《苦涩的教训》(The Bitter Lesson)

01:12:57 2019年发表的《苦涩的教训》(The Bitter Lesson)

01:22:14 2024年9月25日发表在《Nature》杂志上的论文《更大、更易指导的语言模型变得不太可靠》(Larger and more instructable language models become less reliable)

01:22:14 2024年9月25日发表在《Nature》杂志上的论文《更大、更易指导的语言模型变得不太可靠》(Larger and more instructable language models become less reliable)

01:24:01 2024年9月20日发表的论文《LLMs仍无法制定计划; LRM 可以吗? OpenAI o1 在 PlanBench 上的初步评估》(LLMs Still Can’t Plan; Can LRMs? A Preliminary Evaluation of OpenAI’s o1 on PlanBench)

01:24:01 2024年9月20日发表的论文《LLMs仍无法制定计划; LRM 可以吗? OpenAI o1 在 PlanBench 上的初步评估》(LLMs Still Can’t Plan; Can LRMs? A Preliminary Evaluation of OpenAI’s o1 on PlanBench)

01:28:29 2017年,美国著名的媒体理论家、作家和纪录片导演,道格拉斯·拉什科夫(Douglas Rushkoff)的文章《向谷歌巴士扔石头》(Throwing Rocks at The Google Bus)

01:28:29 2017年,美国著名的媒体理论家、作家和纪录片导演,道格拉斯·拉什科夫(Douglas Rushkoff)的文章《向谷歌巴士扔石头》(Throwing Rocks at The Google Bus)

01:30:37 莫法特·奥金尼(Mophat Okinyi),非洲内容审核者联盟创始人

01:30:37 莫法特·奥金尼(Mophat Okinyi),非洲内容审核者联盟创始人

01:34:27 蒂姆尼特·格布鲁(Timnit Gebru),出生于厄立特里亚、埃塞俄比亚的计算机科学家,Google前员工,分布式人工智能研究院(DAIR)的创始人

01:34:27 蒂姆尼特·格布鲁(Timnit Gebru),出生于厄立特里亚、埃塞俄比亚的计算机科学家,Google前员工,分布式人工智能研究院(DAIR)的创始人

01:39:54 玛格丽特·米切尔(Margaret Mitchell),Google前员工,Hugging Face的首席AI伦理科学家

01:39:54 玛格丽特·米切尔(Margaret Mitchell),Google前员工,Hugging Face的首席AI伦理科学家

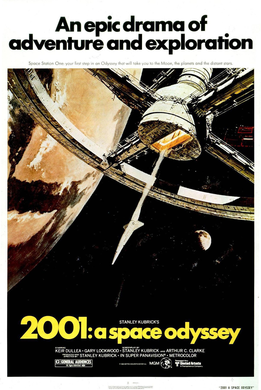

01:44:30 电影《2001 太空漫游记》

01:44:30 电影《2001 太空漫游记》

【感谢】

【感谢】

特别感谢[AIGC开放社区]和[AI重塑世界]的大力支持,请听友及时订阅微信公众号,查看本播客的文字版内容。欢迎订阅本播客节目,本节目在小宇宙、喜马拉雅、苹果播客、蜻蜓FM、网易云音乐、荔枝FM等平台均已上线。